Introduction

Lors du remplacement d’un ordinateur ou l’évolution de celui-ci, vous hésitez entre le traditionnel disque dur HDD de 2 To ou un SSD de 512 Go pour y loger vos nouvelles données. Indécis entre les deux modèles, vous demandez conseil au vendeur qui vous répondra “prenez le SSD, c’est un peu plus chère mais c’est plus fiable et le système d’exploitation démarrera beaucoup plus rapidement.”

C’est ce que nous allons vérifier dans ce test !

L’architecture des disques durs SSD

En 2008 a débuté l’industrialisation du SSD, nommé comme le remplaçant du disque dur mécanique à plateaux.

Désigné comme un nouveau marché d’avenir, de nombreuses sociétés se sont lancées dans l’aventure (ou pour les plus anciennes ont réorientés leur production) afin d’obtenir une part du marché. Contrairement aux disques durs à plateaux produits par aujourd’hui 3 fabricants, le nombre de fabricants de puces mémoires se comptent par centaines et se délivrent une véritable guerre des prix.

Lors de ce combat “prix, capacité, qualité”, les fabricants ont du faire évoluer leur technologie avec le temps.

L’histoire du SSD est marquée par 3 évolutions de ses puces NAND nommées SLC, MLC et TLC.

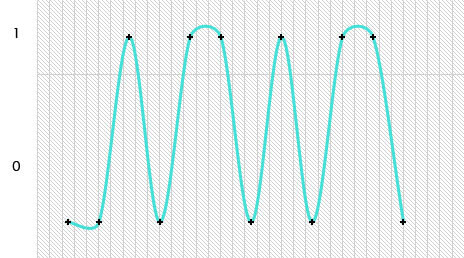

Les puces SLC

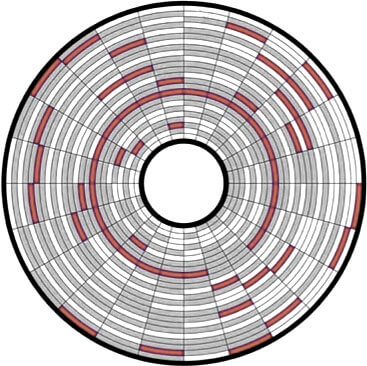

Les premières puces NAND se nomment des SLC (Single Layer Cell soit cellule à simple couche). Ces puces permettent de mémoriser l’état d’un bit de données (soit 1, soit 0). En analysant son signal sur une série de 12 bits, nous pouvons obtenir cette courbe :

Rapidement, les SLC furent bloquées physiquement en espace de stockage. En effet en stockant uniquement deux états possibles (1 ou 0), un nombre important de puces mémoires était requis pour créer une clé usb ou un SSD de grande capacité. Le coût de fabrication d’un média de grande capacité était alors prohibitif pour le grand public.

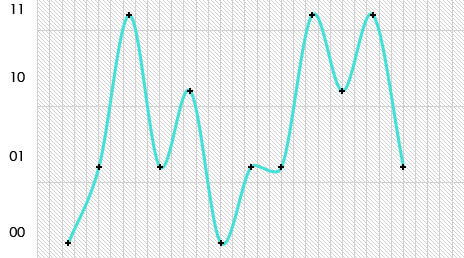

Les puces MLC

Les puces MLC (Multiple Layer Cell) sont apparues pour solutionner le problème des SLC, en ne stockant pas l’état d’un bit de données mais de deux. En analysant son signal sur une série de 12 bits, nous pouvons obtenir cette courbe :

Cette nouvelle technologie a créée de nouveaux problèmes : les erreurs de lecture. Le fait de “comprimer” le signal pour lire 4 états dans le même espace de stockage (même dimension de puce) peut occasionnellement générer des erreurs.

Par exemple avec la vitesse de lecture, un signal 01 peut parfois être confondu avec un 10. Pour rendre le problème invisible pour l’utilisateur, les fabricants ont ajouté d’avantages d’ECC (code de correction d’erreur).

Pour écrire la même donnée sur une puce SLC et une puce MLC, la puce MLC effectuera + d’opérations, se traduisant par une durée de vie plus courte en contrepartie d’une capacité largement accrue.

Comme pour les SLC, avec le temps les utilisateurs demandent de plus en plus de capacité de stockage. Les MLC arrivent donc à leur tour à leur stade d’obsolescence.

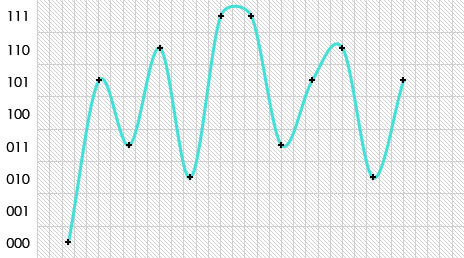

Les puces TLC

Aujourd’hui la technologie la plus récente, les TLC (Triple Layer Cell) permettent de stocker 3 bits de données dans le même espace de stockage. En analysant son signal sur une série de 12 bits, nous pouvons obtenir cette courbe :

Le fonctionnement est strictement identique aux MLC, la courbe est “comprimée” d’avantage pour créer un maximum d’états différents en contrepartie de la fiabilité et d’une durée de vie de plus en plus réduite.

Le stockage sur SSD

Une fausse idée revient souvent “stocker des données sur un SSD, c’est stocker des données sur une mémoire donc ça ne s’use jamais”.

Concrètement, lire une donnée sur une puce mémoire ne l’abîme pas. En revanche, pour écrire une donnée (ou l’effacer/la modifier) le contrôleur va augmenter le voltage à l’endroit désiré pour changer son état. Cette augmentation de voltage va abîmer petit à petit la puce mémoire.

Pour éviter d’abîmer une puce trop rapidement, le contrôleur mémorise chaque cycle d’écriture réalisé sur les puces mémoires.

Prenons l’exemple d’un SSD de 128 Go contenant 8 puces mémoires. Ce SSD contient un système d’exploitation et des photos. Les photos datent de plusieurs mois et ne sont jamais déplacées. Le système d’exploitation quant à lui, a besoin de fichiers temporaires, de bases de données, de fichiers qu’il télécharge par internet (cookies, historique…) Le SSD va pratiquement de manière permanente, modifier des fichiers, en effacer et en créer de nouveaux.

Le contrôleur connait l’état de santé des puces mémoires, il sait que les puces 1 et 2 contenant le système d’exploitation sont d’avantages usées que les puces 3,4,5 et 6 qui contiennent les photos. Pour prolonger la durée de vie du SSD, il va déplacer, de manière invisible pour l’utilisateur, le système d’exploitation sur les puces 3 et 4 et les photos vers les 1 et 2 et ainsi de suite avec le temps.

Ainsi, les puces mémoires s’useront à tour de rôle pour éviter un arrêt de fonctionnement alors que certaines puces sont encore en bonne santé. Les photos, même si l’utilisateur ne les déplace pas, sont autant en danger que le reste.

L’architecture des disques durs HDD

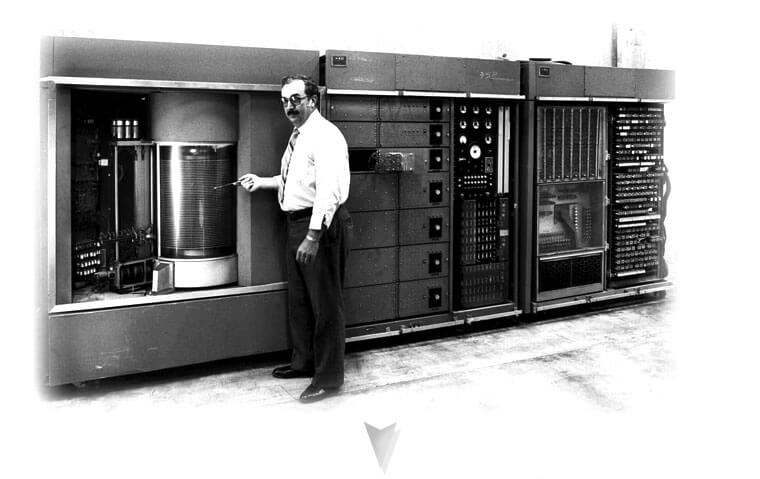

Inventé en 1956, le disque dur est un assemblage de pièces mécaniques piloté par une carte électronique. L’interface entre l’ordinateur et les données est similaire à celle d’un SSD ; le contrôleur est appelé ici firmware et est localisé sur la carte électronique et la surface des plateaux du disque dur.

Les 2 différences flagrantes entre ces 2 architectures se situent au niveau du stockage des données et de leur fabrication.

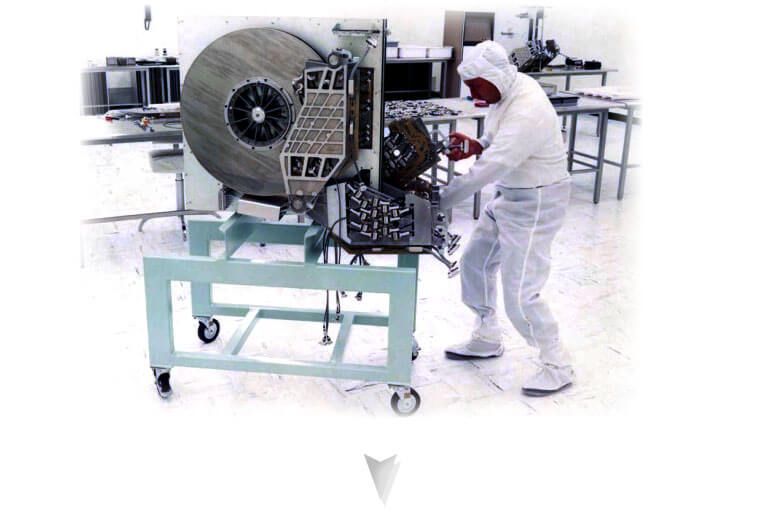

Un plateau de disque dur est composé de plusieurs couches : un alliage d’aluminium, un alliage de platine-cobalt et un alliage de phosphore-nickel. Lors de sa conception en salle blanche, le plateau usiné n’est pas parfait. Certaines zones sont trop lentes ou peu fiables. Avant de pouvoir accueillir des données, une véritable cartographie est créée pour répertorier d’un côté les zones utilisateurs et d’un autre les zones inutiles. Chaque plateau est donc différent. Ces informations sont écrites dans le firmware du disque dur afin de lui allouer des zones saines de lecture/écriture.

Ainsi, dans leur ligne de production, les plateaux les plus performants en vitesse et en capacité, rejoindront d’autres plateaux similaires et seront assemblés dans des disques durs haut de gamme et de forte capacité ; les plateaux plus lents iront vers des gammes plus économiques et les plus dégradés seront utilisés pour des plus petites capacités.

Il est ainsi possible d’observer deux disques durs strictement identiques (même marque et modèle..) mais physiquement très différent, l’un avec 1 plateau de 1 To et l’autre avec 2 plateaux de 500 Go par exemple.

Cette méthode d’assemblage permet une faible perte de matière lors de la fabrication des disques durs mais augmente la difficulté pour les sociétés de récupération de données de trouver des pièces identiques et compatibles pour les disques durs patients.

Evolution

La miniaturisation des pièces mécaniques a permis une véritable réduction de leur taille et une augmentation de la concentration des données présentes sur les plateaux. Le fonctionnement de base à quant à lui très peu changé.

Côté fonctionnement, lorsque l’utilisateur souhaite écrire ou accéder à une donnée, le bloc de têtes de lecture, piloté par la carte électronique et son interface (firmware), sort de sa zone de stockage pour accéder à endroit précis sur les plateaux. Le signal de lecture ou d’écriture est alors transmis par le(s) slider(s) (le bout de la tête de lecture au plus proche des plateaux).

Philosophie

Le SSD peut-il alors prétendre être le remplaçant du HDD ? Non, nous ne le pensons pas. Ces deux technologies possèdent des atouts et des points faibles et ne remplissent pas la même mission.

Le SDD est un bon support de stockage en lecture exclusivement, écrire des données ou en supprimer le dégrade et le rend dangereux dans le temps.

Le HDD quant à lui est moins rapide que le SSD, il est également plus fragile et sensible aux vibrations, variations de température et surtout, aux chocs. Si celui-ci est bien traité dans une unité centrale ou un serveur aéré, au circuit de ventilation régulièrement nettoyé, celui-ci ne possède pas de date de défaillance programmée comme son homologue.

En fonction du besoin de chacun entre la rapidité, la sécurité et le coût, il conviendra de choisir habilement son média.

Exemples d’utilisations

Pour stocker des données dites “froides”, c’est à dire, des fichiers mp3, des films ou des images ; un SSD peut être une bonne idée, dans la condition que celui-ci ne possède pas de système d’exploitation.

Dans une optique “jeux vidéo” ou client léger, utiliser un SSD pour y loger son système d’exploitation est une bonne idée pour le rendre plus rapide. A condition qu’il ne partage pas son espace avec des données importantes et que son utilisateur soit conscient que son SSD est “jetable” et devra être remplacé au bout de 3/4 ans.

Pour un ordinateur portable/tablette ne contenant pas de données cruciales (uniquement pour l’OS et des applications de messagerie par exemple) encore une fois le SSD excelle dans son domaine.

Pour une utilisation d’ordinateur familial contenant un système d’exploitation et des données, le HDD est alors recommandé.

Dans une optique de stockage de résultats de machines-outils, ou de données nécessitant d’être accessibles par plusieurs personnes en même temps et de travailler dessus, le HDD est également plus sécurisant.

Dans un serveur ou une baie de stockage le disque dur est également le meilleurs choix en termes de sécurité et longévité.

Conclusions

Le SSD est certes plus rapide, il ne convient pas forcément à toutes les applications. Considéré comme “jetable” il sera votre meilleur allié pour y loger votre système d’exploitation. Les données sensibles et précieuses peuvent y être logées à condition qu’aucun système d’exploitation ne soit présent sur celui-ci. Dans tous les autres cas, et principalement pour les données importantes, les serveurs et l’utilisation en entreprises, le HDD sera plus fiable, celui-ci ne possède pas de date de mort programmée si correctement stocké, ventilé et loin de tout choc physique possible.

Vous subissez une perte de données ?